!!

以前こんなブログを書きましたが、results配下のログをfluentdでS3に飛ばせますぜ!!と書いていましたが、vuls report -to-s3で簡単に飛ばせますw 今回完全に忘れていたので設定してみました。(意外と知らない人多そう⇛自分だけか!)

■Example: Put results in S3 bucket

https://vuls.io/docs/ja/usage-report.html#example-put-results-in-s3-bucket

- S3でバケット作成(vuls.report)

- IAMでポリシーの追加

- IAMでvulsユーザーの作成と上記のポリシーをアタッチ

- サーバ上でクレデンシャルの設定

- config.tomlにバケットの指定

終わり!!

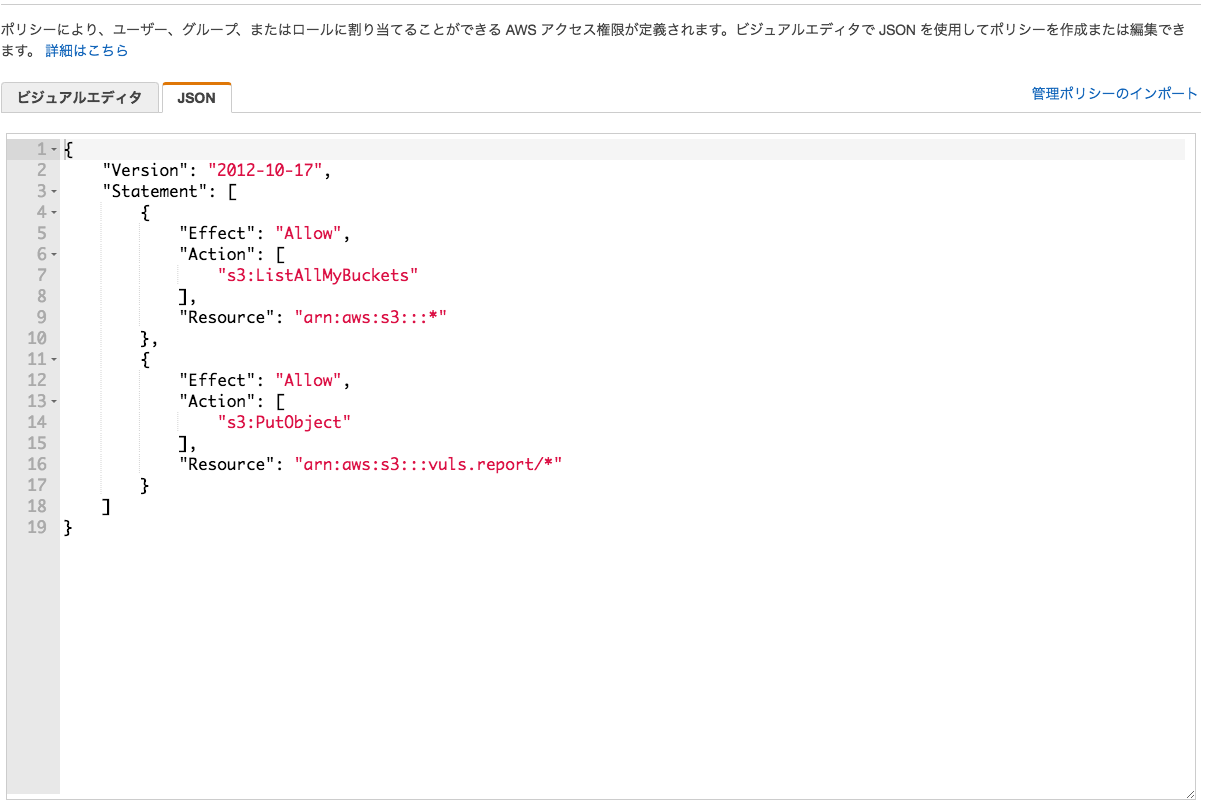

■IAM

・policy

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 |

{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "s3:ListAllMyBuckets" ], "Resource": "arn:aws:s3:::*" }, { "Effect": "Allow", "Action": [ "s3:PutObject" ], "Resource": "arn:aws:s3:::vuls.report/*" #バケット名を指定 } ] } |

とりあえずvuls.reportというバケットを作って上記のポリシーを新規で作成します。

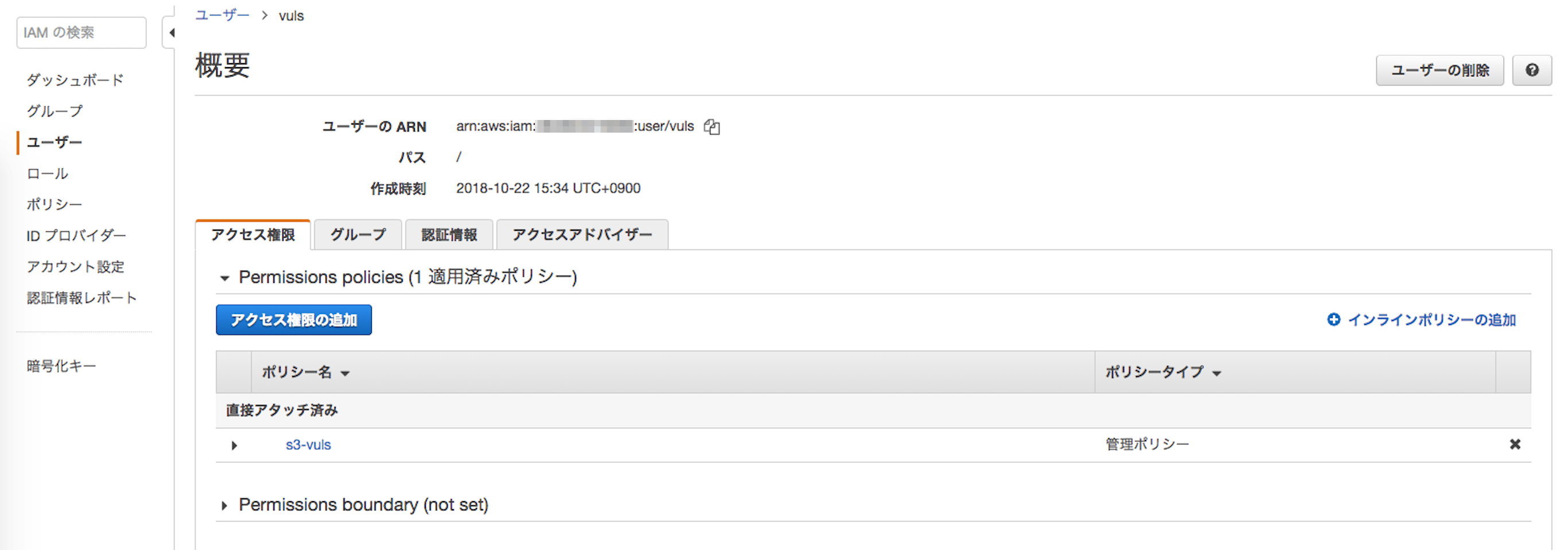

・user

あとは先程のポリシーをvulsユーザーに追加したらクレデンシャルをVulsサーバにぶち込みます。

・setting credentials

|

1 2 3 4 5 6 7 8 9 10 11 12 13 |

$ tree .aws/ .aws/ ├── config └── credentials $ cat config [default] region = ap-northeast-1 $ cat credentials [default] aws_access_key_id = xxxxxxxxxxxxxxxx aws_secret_access_key = xxxxxxxxxxxxxxxxxxxxxxxxxxxx |

■config.toml

|

1 2 3 4 5 |

[aws] profile = "default" region = "ap-northeast-1" s3Bucket = "vuls.report" s3ServerSideEncryption = "AES256" |

ちなみにAES256は(Advanced Encryption Standard)の256ビット長の暗号鍵を指定しているのでS3に転送時はかなり高セキュアということになります。

■vuls report!!

|

1 |

$ vuls report -format-one-line-text -format-json -to-slack -to-s3 -cvss-over=7 -lang=ja -ignore-unfixed |

-to-s3を追記して確認してみましょう。下記の自動スキャン/レポートスクリプトもおすすめ!!

・vuls-autoscan.sh

https://gist.github.com/RVIRUS0817/5228ead105329438f8f643d6b1849bd0

・S3

ちゃんと日別で同期されてますな!!!

■まとめ

fluentdもう使わなくてOK!

このログらをElasticSearchに取り込んで、Kibanaで可視化するやり方をうっしーさんが Qiitaに書いてます。(下記より)ということは!!AthenaやらBigQueryに同期してRedashで可視化できるやん!

・VulsのログをElasticSearchに取り込んで可視化する

https://qiita.com/usiusi360/items/28e40f7044db73c407bc

0件のコメント